在當今信息爆炸的時代,數據處理已成為各行各業不可或缺的核心環節。數據處理是指對原始數據進行收集、清洗、轉換和分析的過程,旨在從中提取有價值的信息和洞察,為決策提供科學依據。

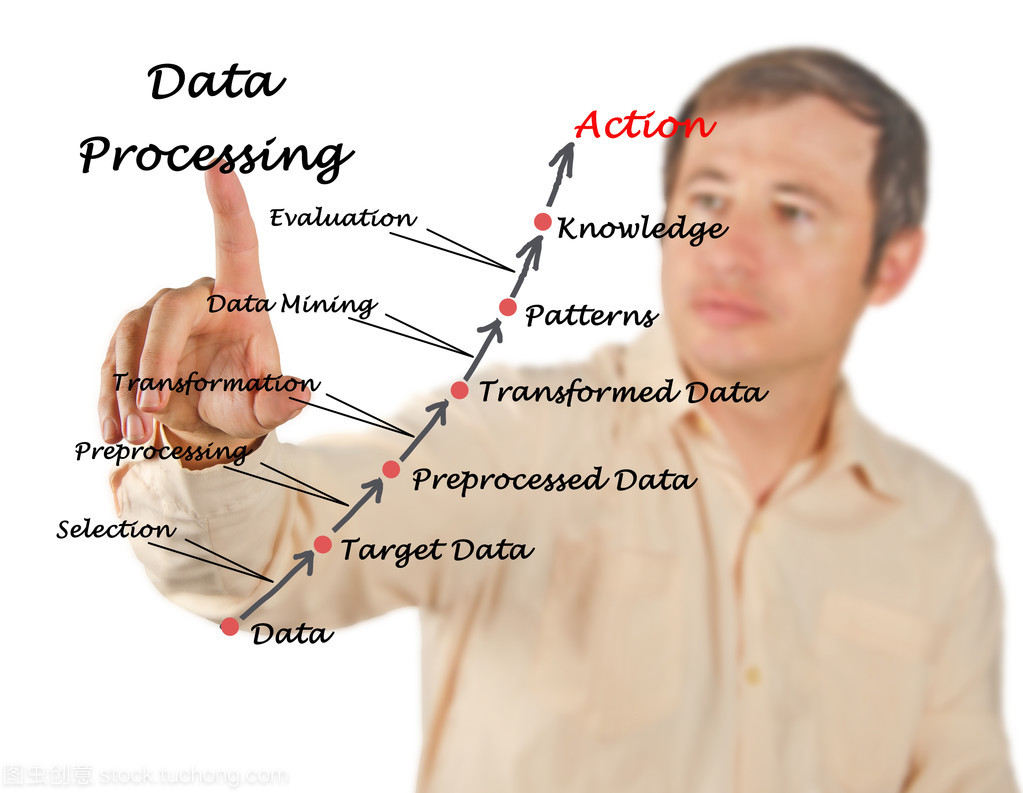

一、數據處理的基本流程

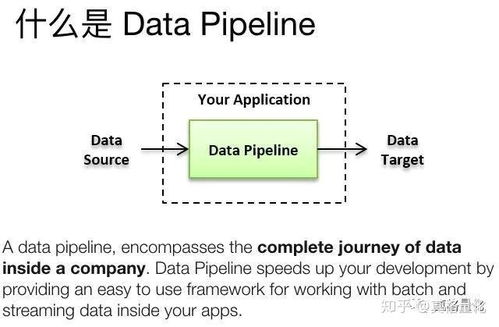

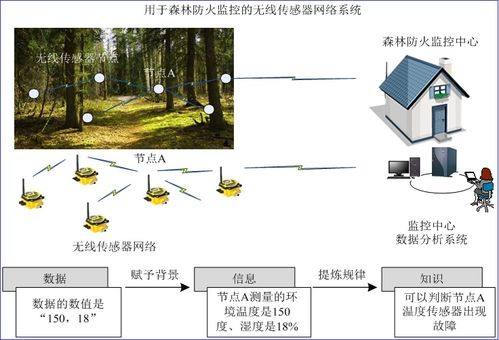

數據處理通常包含四個關鍵步驟:數據收集、數據清洗、數據轉換和數據分析。數據收集階段涉及從各種來源獲取原始數據,包括傳感器、數據庫、日志文件等。然后,在數據清洗階段,專業人員會識別并處理缺失值、異常值和重復數據,確保數據質量。數據轉換階段將數據轉化為適合分析的格式,可能包括歸一化、聚合或特征工程等操作。數據分析階段運用統計方法、機器學習算法等手段,從數據中挖掘模式和趨勢。

二、數據處理的技術方法

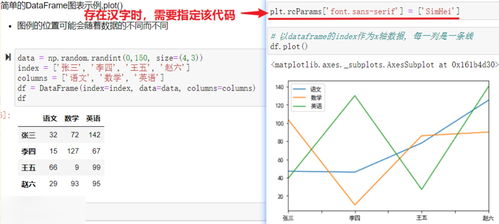

現代數據處理技術日新月異,從傳統的關系型數據庫到分布式計算框架,都為高效處理海量數據提供了可能。SQL仍然是處理結構化數據的主要工具,而Python和R等編程語言則因其豐富的數據處理庫(如Pandas、NumPy)而廣受歡迎。對于大數據場景,Hadoop和Spark等分布式計算框架能夠并行處理TB甚至PB級別的數據。數據可視化工具(如Tableau、Power BI)幫助將處理結果以直觀的圖表形式呈現,使非技術人員也能理解數據背后的故事。

三、數據處理的挑戰與對策

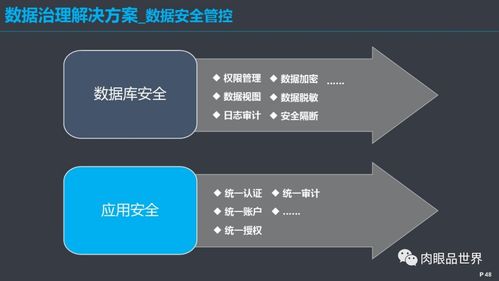

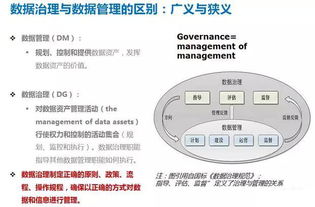

盡管數據處理技術不斷進步,從業者仍面臨諸多挑戰。數據質量問題、隱私安全風險和計算資源限制是常見的難題。為應對這些挑戰,企業需要建立完善的數據治理體系,制定嚴格的數據質量標準,并采用適當的數據加密和訪問控制措施。同時,云計算的普及為解決計算資源問題提供了彈性且成本效益高的解決方案。

四、數據處理的未來趨勢

隨著人工智能和物聯網的發展,數據處理正朝著更智能、更實時的方向演進。邊緣計算使得數據能在產生地點就近處理,減少了傳輸延遲;自動化機器學習(AutoML)降低了數據分析的技術門檻;而聯邦學習等隱私保護技術則在保障數據安全的前提下實現了多方數據協作。這些創新將進一步拓展數據處理的應用邊界,為智慧城市、精準醫療等領域帶來革命性變化。

數據處理是將原始數據轉化為商業價值和科學發現的關鍵橋梁。掌握數據處理技能不僅有助于個人職業發展,更是組織在數字化時代保持競爭力的必備能力。隨著技術的不斷演進,數據處理必將在推動社會進步中發揮更加重要的作用。