在當今數據驅動的時代,高效、準確地處理海量數據已成為企業提升競爭力的關鍵。手動處理數據不僅耗時耗力,還容易出錯,難以滿足快速迭代的業務需求。因此,構建自動化的數據流水線(Data Pipeline)成為了一種高效、可靠的解決方案。本文將探討如何利用數據流水線實現數據處理工作的自動化,涵蓋其核心概念、構建步驟及最佳實踐。

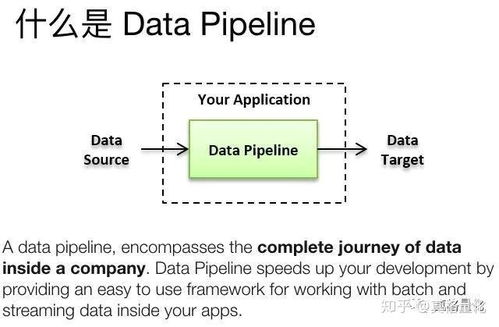

一、 什么是數據流水線?

數據流水線是一個自動化的流程,用于將數據從源系統提取、轉換并加載到目標存儲或分析系統中。它類似于工廠的生產線,將原始數據(原材料)經過一系列預定義的處理步驟(加工),最終輸出為可供消費的、高質量的數據產品。一個典型的數據流水線通常包括數據提取(Extract)、數據轉換(Transform)和數據加載(Load)三個階段,即常說的ETL過程。

二、 為什么需要自動化數據處理流水線?

- 提升效率與速度:自動化流水線可以7x24小時不間斷運行,處理速度遠超人工,能快速響應業務對最新數據的需求。

- 保證數據質量與一致性:通過預定義的規則和校驗步驟,自動化處理能減少人為錯誤,確保數據處理結果的一致性和可靠性。

- 增強可重復性與可追溯性:每個處理步驟都被記錄和版本控制,便于復現結果、排查問題及滿足審計要求。

- 釋放人力資源:將數據工程師和分析師從重復性勞動中解放出來,使其能專注于更高價值的任務,如數據建模、分析和洞察挖掘。

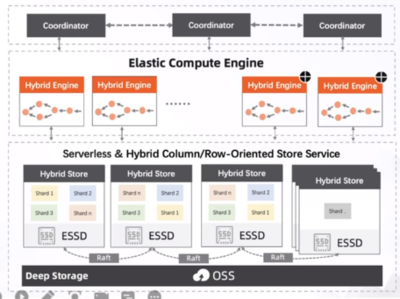

- 支持復雜與大規模處理:能夠輕松編排復雜的依賴任務,并利用分布式計算框架處理PB級的數據。

三、 構建自動化數據流水線的關鍵步驟

- 需求分析與設計:明確數據來源、目標、處理邏輯(如清洗、聚合、關聯)、輸出頻率(實時、每日批處理)以及服務質量(如SLA)要求。設計流水線的整體架構和組件。

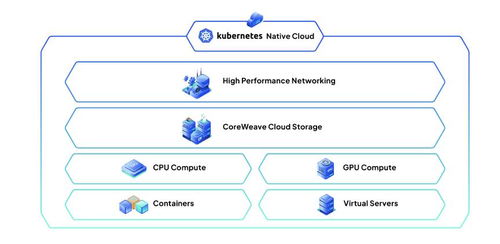

- 選擇合適的技術棧:根據數據量、處理速度要求和技術團隊能力,選擇工具。常見選擇包括:

- 編排與調度:Apache Airflow, Luigi, Prefect, Dagster。

- 數據處理框架:Apache Spark, Apache Flink, Pandas(適用于中小規模)。

- 工作流即服務:AWS Step Functions, Google Cloud Dataflow, Azure Data Factory。

- 實現核心處理邏輯:

- 提取:從數據庫、API、日志文件、消息隊列等源系統安全地抽取數據。

- 轉換:執行數據清洗(去重、處理缺失值、格式標準化)、數據轉換(計算衍生指標、聚合)和數據豐富(關聯其他數據源)。

- 加載:將處理后的數據加載到數據倉庫(如Snowflake, BigQuery, Redshift)、數據湖或指定的應用數據庫中。

- 添加監控與告警:為流水線設置關鍵指標監控(如任務執行狀態、耗時、數據量、數據質量校驗失敗率),并配置異常告警(通過郵件、Slack等),確保問題能被及時發現和處理。

- 測試與部署:對流水線的每個組件進行單元測試和集成測試。使用CI/CD(持續集成/持續部署)流程自動化部署流水線更新,確保變更安全可控。

- 文檔與維護:詳細記錄流水線的設計、依賴、運行方式和維護手冊。定期回顧和優化流水線性能及成本。

四、 最佳實踐與注意事項

- 模塊化與可重用性:將流水線拆分為獨立、可重用的組件或任務,便于維護、測試和組合新流程。

- 處理失敗與重試機制:設計健壯的錯誤處理邏輯,包括自動重試、失敗通知以及從特定斷點恢復的能力。

- 數據質量內嵌:在轉換過程中加入數據質量檢查規則(如有效性、完整性、一致性校驗),并能使失敗的數據進入隔離區供審查。

- 版本控制:對流水線代碼、配置乃至數據處理邏輯本身進行版本控制(如使用Git),確保可追溯和可回滾。

- 成本與性能優化:監控資源消耗,優化處理邏輯(如分區、索引、緩存),選擇性價比高的資源類型和規模,特別是使用云服務時。

- 安全與合規:確保數據在傳輸和靜態時加密,實施嚴格的訪問控制,并遵守相關的數據隱私法規(如GDPR)。

五、

構建自動化的數據流水線是將數據處理工作從一項手工藝轉變為現代化、工業化生產的關鍵。它通過標準化、自動化的流程,顯著提升了數據處理的效率、可靠性和可擴展性。成功實施數據流水線需要精心的規劃、合適的技術選型以及對數據質量、監控和運維的持續關注。隨著技術的演進,更智能、更易用的流水線工具不斷涌現,使得各類組織都能更輕松地駕馭數據洪流,挖掘數據價值,驅動智能決策。