KinectFusion是微軟研究院開發的一項實時三維重建技術,它利用Kinect深度攝像頭捕捉環境數據,并通過高效的算法實現動態的三維場景建模。數據處理是KinectFusion的核心環節,直接決定了重建的精度和實時性。本文將簡要介紹KinectFusion數據處理的基本流程和關鍵技術。

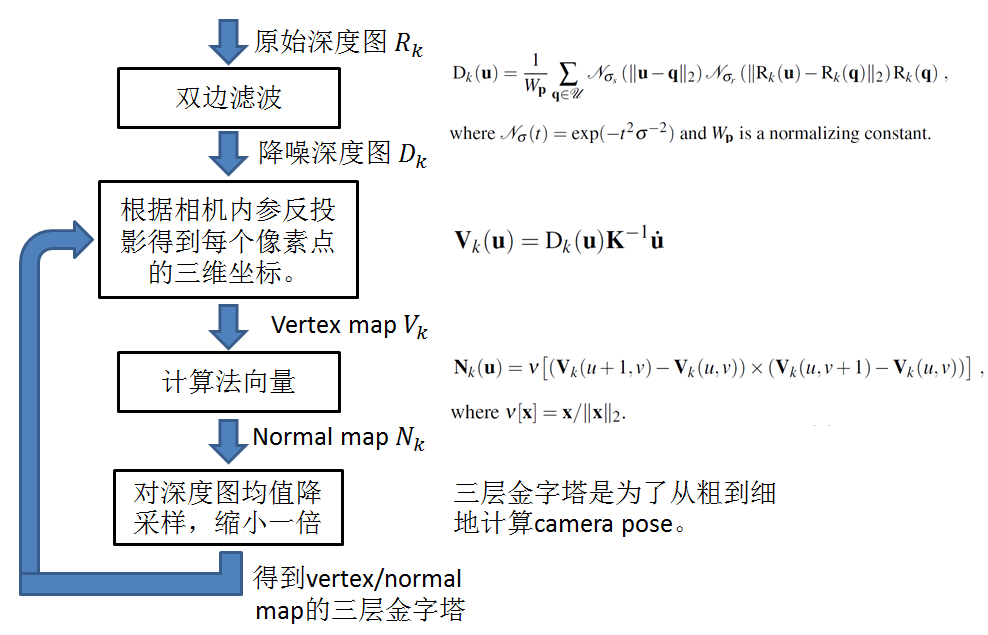

KinectFusion的數據處理從深度數據采集開始。Kinect設備每秒生成多幀深度圖像,每個像素點包含場景中對應點的距離信息。這些原始數據通常存在噪聲和缺失值,因此需要進行預處理,包括濾波(如雙邊濾波)以平滑數據,并填充無效像素,以提高后續處理的穩定性。

接下來是數據配準與融合步驟。KinectFusion使用迭代最近點(ICP)算法將當前幀的深度數據與已有的三維模型進行對齊,估計攝像頭的位姿變化。一旦位姿確定,新采集的深度數據會被轉換為三維點云,并融合到全局的體素網格中。這個過程涉及體素化表示,其中每個體素存儲截斷符號距離函數(TSDF)值,用于表示表面距離和權重。通過加權平均,系統能夠逐步優化模型,適應動態場景變化。

然后,數據處理包括表面重建和渲染。KinectFusion利用移動立方體(Marching Cubes)算法從TSDF體素網格中提取等值面,生成三角網格模型。這允許實時可視化重建的三維場景。同時,系統會管理內存,僅更新可見區域的體素,以保持計算效率。

在數據處理中,KinectFusion還面臨挑戰,如處理大尺度場景時的內存限制和實時性要求。為此,研究人員開發了優化技術,例如分層體素表示和GPU加速,以提升性能。KinectFusion的數據處理流程體現了從原始深度數據到精細三維模型的完整轉換,為虛擬現實、機器人導航等應用奠定了堅實基礎。通過持續改進,這項技術正推動著實時三維感知的發展。