在信息爆炸的時代,海量數據處理已成為各行各業面臨的共同挑戰。傳統的數據處理工具與方法在處理TB、PB乃至EB級別的數據時,往往顯得力不從心,存在性能瓶頸、擴展性差和成本高昂等問題。為了解決這一難題,以Hadoop為代表的分布式計算框架及其核心編程模型MapReduce應運而生,為海量數據處理開辟了全新的路徑。

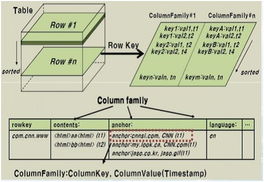

Hadoop框架是一個開源、高可靠、高擴展的分布式系統基礎架構,其核心設計思想源自Google的GFS和MapReduce論文。它主要由Hadoop Distributed File System(HDFS)和MapReduce計算模型兩大部分構成。HDFS負責海量數據的分布式存儲,它將大文件分割成多個數據塊(Block),并將這些數據塊冗余存儲在集群中的多個節點上,從而實現了數據的高容錯性和高吞吐量訪問。這種存儲方式為后續的并行計算奠定了堅實的基礎。

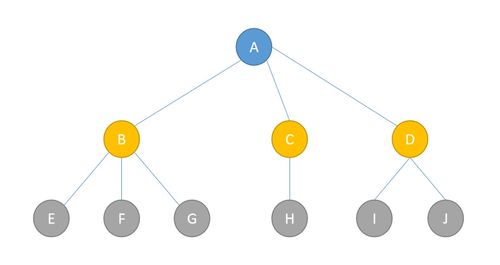

而MapReduce則是Hadoop處理海量數據的核心計算范式。它將復雜的計算任務抽象為兩個主要階段:Map(映射)和Reduce(歸約)。在Map階段,輸入數據被分割成獨立的片段,由集群中的多個節點并行處理,每個節點對其分配的數據片段執行用戶定義的Map函數,生成一系列的中間鍵值對(key-value pairs)。這些中間結果經過一個Shuffle(混洗)過程,將相同key的數據匯聚到同一個節點。隨后進入Reduce階段,該節點對匯聚過來的、屬于同一key的所有value執行用戶定義的Reduce函數,最終產生輸出結果。

這種“分而治之”的模式具有顯著優勢。它實現了極高的并行性,通過增加集群中的節點數量,可以線性地提升數據處理能力,輕松應對數據規模的持續增長。它將計算任務移動到數據所在的節點(移動計算而非移動數據),極大地減少了數據在網絡中的傳輸開銷。其編程模型相對簡單,開發者只需關注Map和Reduce兩個核心邏輯,而無需操心復雜的分布式系統問題,如任務調度、節點通信和容錯處理等,這些都由Hadoop框架自動管理。當某個計算節點失敗時,框架能夠自動檢測并將該節點上的任務重新調度到其他健康節點執行,確保作業的最終完成。

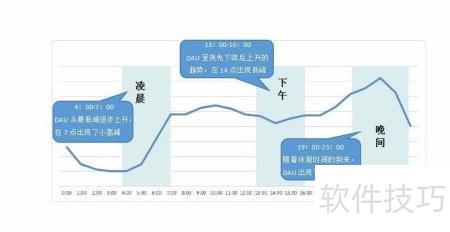

Hadoop與MapReduce的應用場景極為廣泛。從互聯網公司的用戶日志分析、搜索引擎的網頁索引構建,到金融領域的風險建模與欺詐檢測,再到生物信息學的基因序列分析,其身影無處不在。它使得從海量、多源、異構的數據中挖掘有價值的信息變得可行且高效。

技術也在不斷演進。經典的MapReduce模型由于其基于磁盤的中間結果存儲和較為固定的兩階段模型,在處理需要多輪迭代或實時交互的場景時存在延遲較高的問題。因此,在Hadoop生態之上,又誕生了如Spark這樣基于內存計算的下一代計算框架,它通過彈性分布式數據集(RDD)等抽象,在兼容MapReduce優點的顯著提升了迭代計算和交互式查詢的性能。

Hadoop框架及其MapReduce模式是海量數據處理發展史上的里程碑。它們不僅提供了切實可行的技術解決方案,更重要的是,其背后所蘊含的分布式、并行化、面向大規模廉價硬件的設計哲學,深刻影響了整個大數據技術棧的發展。理解Hadoop與MapReduce,是理解現代大數據處理技術基石的關鍵一步。隨著數據規模的持續膨脹和應用需求的不斷深化,其核心思想仍將在新的技術形態中延續與升華,繼續驅動著海量數據處理能力的邊界不斷拓展。